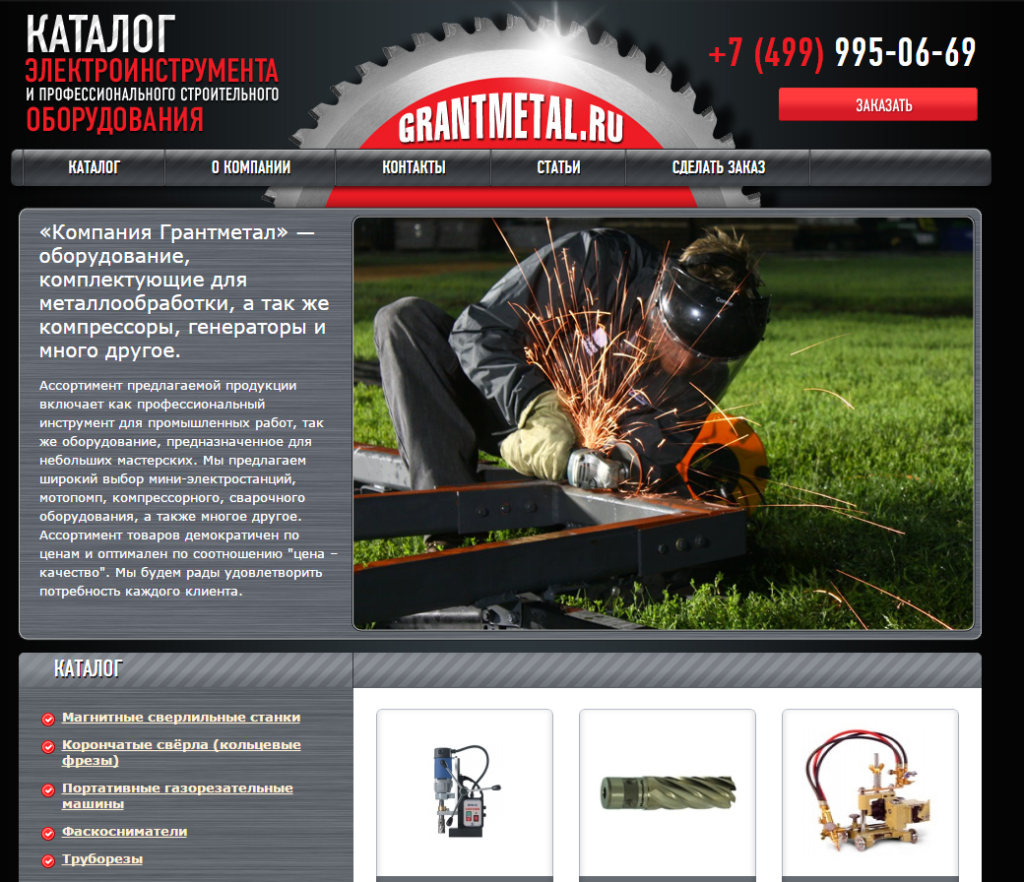

Я решил немного понастальгировать и поделиться историями из своего опыта о которых ранее не рассказывал. Сегодня речь пойдет о старом интернет-магазине промышленного оборудования — Grantmetal.ru. Клиент пришел ко мне сначала с сайтом ridgidshop.ru, а после успешной нейтрализации бана в Яндексе и Google передал мне и этот сайт. Я засучил рукава и начал работу.

Чтение этой статьи займет: 9 минут.

Сайт: grantmetal.ru

Бюджет: 30 000 руб.

Задача: Вывести сайт из под фильтров АГС Яндекс и Google Panda.

Сроки: 1,5 месяца.

Содержание публикации:

Предыстория

Немного предыстории. Я познакомился с клиентом весной 2013 года, когда он обратился ко мне с просьбой вывести сайт из под фильтров АГС и Панда свой сайт ridgidshop. Сайт был достаточно быстро выведен из под фильтров, а затем продвинут на хорошие позиции, после чего клиент передал мне grantmetal на аналогичное обслуживание. То была осень 2013 года.

Аналитика

Я досконально изучаю каждый новый проект. Так было 7 лет назад, когда я только начинал свою работу в SEO, так продолжается и сейчас. Самая грубая ошибка любого специалиста — полагаться только на свой опыт. Любой опыт может быть непредсказуем в конченом счете, так что лучший вариант — проводить полную проверку сайта. Как я уже говорил, накануне я вывел сайт с аналогичными симптомами (ridgidshop) и все же мне хотелось проверить данные.

Grantmetal, на тот момент был молодым сайтом, который прошел только первые круги Ада развития. Клиент решил самостоятельно заниматься развитием проекта и всего за 9 месяцев ему удалось загнать сайт под АГС. Я понимал, что виной тому могут быть два фактора: купленные самостоятельно некачественные ссылки или плохой контент. В первую очередь я запустил проверку текстовой уникальности. В то время на этот процесс у меня ушло порядка двух суток. Сейчас технологии по проверки уникальности сайтов заметно шагнули вперед.

А пока шло время проверки, я занялся плотным изучением ссылочного профиля и других параметров сайта. И вот что мне удалось обнаружить.

Техническая оптимизация

На сайте отсутствовал файл robots.txt, отсутствовала карта сайта xml. Главная страница имела по меньшей мере 3 дубля. Порядка 10 страниц сайта отдавали 404 ответ. Следовательно, при отсутствующем файле robots.txt сайт отдавал под индексацию кучу собственных дублей и другой лишней информации. Поисковые системы отказались индексировать такой сайт. Чтобы не тратить время даром, я исправил все эти ошибки. Прописал конфигурации robots.txt, сделал актуальную карту сайта (но пока не стал скармливать ее боту — об этом чуть позже). Удалил и заредеректил все битые ссылки, ликвидировал дубли при помощи 301 редиректа.

Уникальность сайта

Пока я проделывал эти работы подготовился долгожданный отчет по уникальности страниц сайта. В отчете было обнаружено много интересного и полезного.

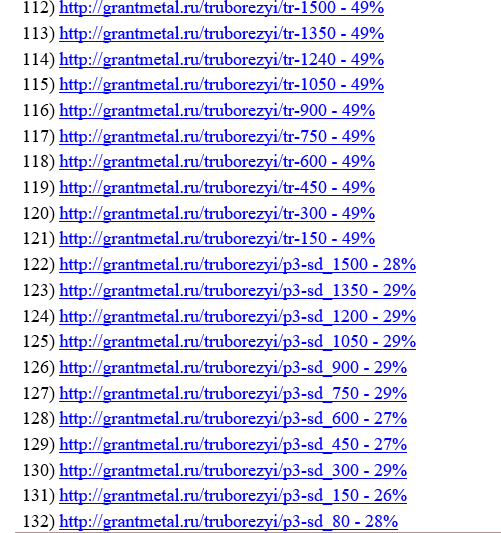

Вот как это выглядело:

Большая часть страниц имела уникальности ниже 50%. Одним словом, клиент воспользовался низкокачественными рерайтами. Я был уверен в том, что это и есть основная причина наложения фильтра, поэтому быстро собрал органическую семантику и раздал задания копирайтерам на создание уникальных описаний для более чем 200 страниц сайта. Эта работа заняла еще 2 недели. Тексты были написаны и размещены на сайте. Выглядело это так:

Вторым сюрпризом по уникальности сайта был неуникальный прайс-лист, который был спарсен у конкурентов. Клиент сразу сообщил мне о том, что сделать уникальным данный прайс-лист не представляется возможным и тогда я решил применить следующее решение. Я поместил в файл robots.txt конфигурацию запрещающую поисковым роботам индексировать данный прайс.

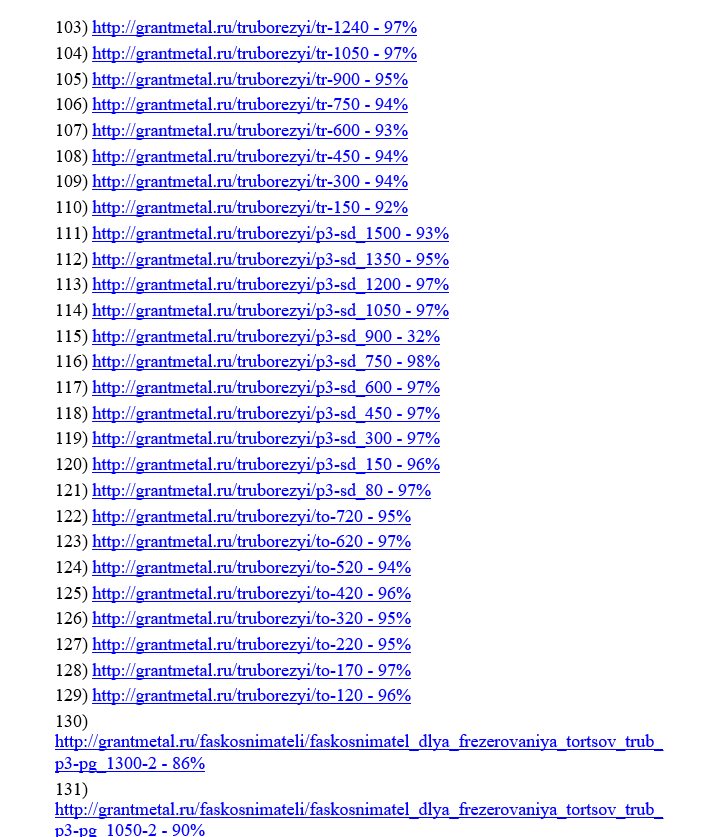

Так я разобрался с неуникальностью сайта, сумев повысить среднюю уникальность проекта с 28% до 82%. Вот так выглядела уникальность страниц, посл проведения работ по повышению уникальности сайта:

Мета данные

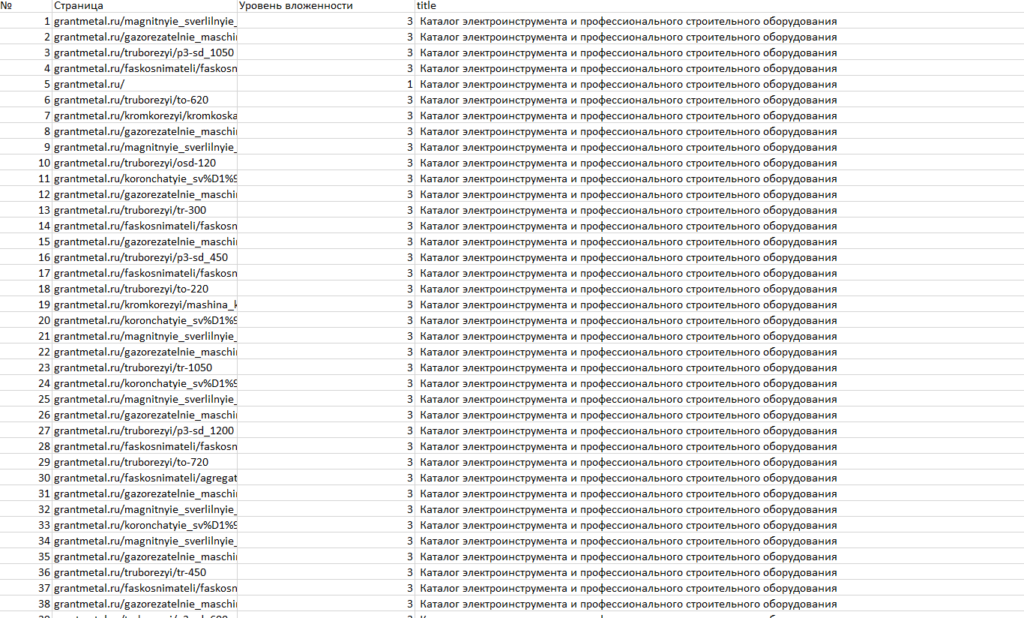

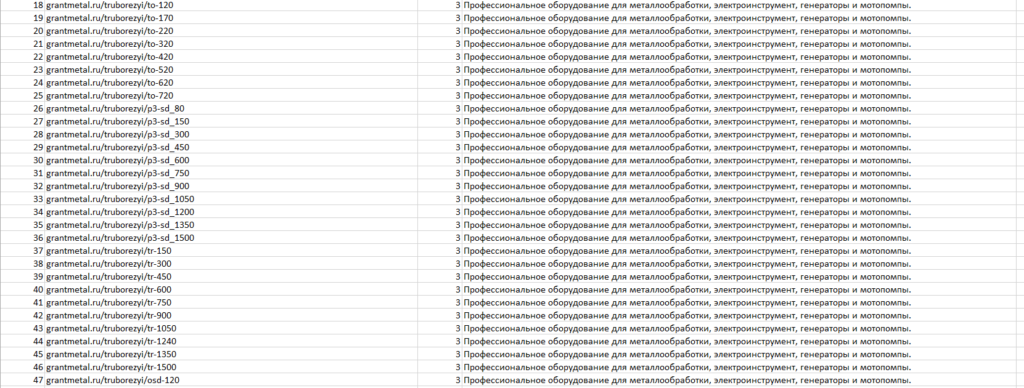

При анализе я также не обошел основу основ текстовой релевантности — мета данные. Именно благодаря мета-данным поисковый робот определяет первичную принадлежность сайта той или иной тематике. Неуникальные мета-теги — грубейшая ошибка из всех возможных. Именно это мне довелось наблюдать на данном проекте:

Я набрался терпения, налил несколько чашек чая и приступил за работу. Покончив с тегами Title, я приступил к description, который имел аналогичную проблему:

Ссылочный профиль

Конечно же клиент закупал некачественные ссылки. К сожалению, я утратил архив с диаграммой ссылочного профиля и по этой причине не могу Вам его продемонстрировать. Но зато я хорошо заполнил, что ссылки снимались с бирж автоматической закупки ссылшок (иначе говоря, такие агрегаторы как Seopult и Webeffector). Было принято решение снять все ссылки без исключений.

Переписка с Яндексом

Когда все работа были выполнены, я начал общение с Яндексом. Я сообщил о том, что сайт прошел ряд улучшений. Сообщил о том как был обновлен контент, как проведена техническая и внутренняя оптимизация сайта. Итогом моего письма стала просьба о рассмотрении заявки на вывод из под фильтра.

У Google нет подобной технической поддержки, но обратной стороной медали является то, что Google гораздо быстрее индексирует сайты. Поэтому самым простым решением было скормить Google обновленную карту сайта.

Точно также я поступил и с Яндексом. После всех улучшений я наконец скормил Яндексу карту сайта и дал проиндексировать все страницы.

Итоги и результат

На проведение всех работ ушло около 3 недель. Это был очень интенсивный период работ. И вот, спустя 44 дня работ, результат:

Вновь приятным бонусом для клиента стало и то, что помимо самого вывода сайт обрел хорошее качество и стал неплохо ранжироваться в поисковых системах и получать трафик. В дальнейшем я стал заниматься продвижением данного проекта.

Что нужно чтобы не попасть под АГС

Сейчас алгоритм обновился. Все большее внимание уделяется ссылкам. Вот несложные рекомендации, которые помогут Вам избежать данной проблемы в будущем:

- Не закупайте некачественные ссылки. Если не владеете основами линкбилдинга и не читали Эрика Уорда, то лучше вообще не заниматься самостоятельной закупкой ссылок.

- Следите за уникальностью и качеством контента.

- Следите за мета-тегами.

- Содержание каждой страницы должно быть уникальным «от» и «до». Это касается мета-тегов, микроразметки, тела страницы.

- Соответственно рекомендую скрывать любые дубли страниц.